TTTC:empty vocabulary

Talk to the Cityにおける未解決問題

僕は2024-09-11ごろ体験した

TTTCをAzure OpenAIで使うのを試してコードを書き換えたりしている最中だったので自分の環境でだけ発生するものだと思っていた

2024-09-16

2024-09-28

これが正攻法での解決方法だと思う

がしかしそもそもどういう時に発生するのかが謎

2024-10-29

2024-10-29現在は日テレNEWS×2024衆院選×ブロードリスニングのバージョンのソースコードが公開されてるのでそれを使うのが楽

わかっていることメモ

>ValueError: empty vocabulary; perhaps the documents only contain stop words

clusteringのここで発生する

: _, __ = topic_model.fit_transform(docs, embeddings=embeddings)(9/11)返り値を使ってないように見えるがこの行自体は必要

>Talk to the Cityの“BERTopicつかってないのでは?“という話に関して_, __ = topic_model.fit_transform(docs, embeddings=embeddings)をコメントアウトしたら下のresult = topic_model.get_document_infoで ValueError: This BERTopic instance is not fitted yet. Call 'fit' with appropriate arguments before using this estimator.になったので使ってはいる、返り値を使わずにmodelの内部状態か更新されてるだけ(だったら_, __ =ってかかなくていいのに) ということがわかりました

(9/11)PDBで追いかけてみたが途中で断念

:409 else:

410 # Extract topics by calculating c-TF-IDF

411 -> self._extract_topics(documents, embeddings=embeddings):(Pdb) self._c_tf_idf(documents_per_topic)

*** ValueError: empty vocabulary; perhaps the documents only contain stop words:3485 if partial_fit:

3486 X = self.vectorizer_model.partial_fit(documents).update_bow(documents)

3487 -> elif fit:

3488 self.vectorizer_model.fit(documents)

3489 X = self.vectorizer_model.transform(documents)

3490 else:

3491 X = self.vectorizer_model.transform(documents)

(Pdb) self.vectorizer_model.fit(documents)

*** ValueError: empty vocabulary; perhaps the documents only contain stop wordsまあvectorizer_modelは下記なのでCountVectorizerがエラーを出しているのは間違いない

clustering.py CountVectorizer = import_module(

'sklearn.feature_extraction.text').CountVectorizer

...

vectorizer_model = CountVectorizer(stop_words=stop)

topic_model = BERTopic(

umap_model=umap_model,

hdbscan_model=hdbscan_model,

vectorizer_model=vectorizer_model,

verbose=True,

)僕の手元のsklearn.__version__のバージョンは1.3.1だった

tokenizer.get_feature_names_outとかで使われてるfeaturesを見ると、もちろん日本語は単語に分けられてない

defaultで

CountVectorizer(..., token_pattern='(?u)\\b\\w\\w+\\b') なんだから当たり前だと思うむしろ安野都知事選のタイミングでなぜこれで動いてたのかわからない

振り返ってみると6/9の僕のコメント:

>元のソースはクラスタリング部分で英語を前提としたCountVectorizerを使ってるので僕の実験では(世界に向けて見せたかったこともあり)英語で抽出、英語でクラスタリングして結果を和訳したが、翻訳のクオリティの問題はあった。今回は日本人がターゲットなので日本語で抽出、日本語でクラスタリング、翻訳はなし、がいいのではないか。その場合は、クラスタリング部分でBag of Wordsしてるので、日本語の場合は形態素解析かキーワード抽出が必要

この後6/11に「日本語プロンプトでやってみたらできた」という報告があったので、時間もないから動くならそれでいいか、となった

9/16のコメント

>そもそも論としてTTTCのメインの処理の部分は日本語を想定した実装になってなくてストップワードも英語だし形態素解析もしてない。英語でやって結果を和訳するか、日本語が通るように形態素解析を入れるかのどっちかが必要なのではという話になったのだけど、プロンプトを和訳したら問題なく動いたと報告があって、自分の手元でも追試したら確かに動いたので「じゃあいいかー」となった

> 動かない現状の方が僕の理解にマッチする振る舞い

単語に分割できない時に文字での分割にfallbackする仕組みがバージョンによっては入ってるとか?

いま(9/18)CountVectorizer — scikit-learn 1.5.2 documentationを読んでたんだがdefaultのanalyzer='word'を'char'に変えたら動きそうではあるな

Bag of Charsでほんとにいいのかというのはさておき

9/16の投稿:

9/11の発生時はAzure関連だと思ってたので、ライブラリの依存関係を追うのが面倒で真面目な解決を諦めた

代わりに抽出した日本語データに対して英訳を末尾につけるようにプロンプトを修正してワークアラウンドした

>末尾に英語への翻訳をつけてください。

その方法でワークアラウンドできるということは日本語文章のトークナイズに関する問題だろうと思っててる

9/18

今現在の考えとしては

analyzer=‘char’ で動くのでは?と思っている本質的にはちゃんと形態素解析すべきだと思う

CountVectorizerは関数を渡してoverrideできるのでその方法で。

Related Pages

- →デジタル民主主義2030×台湾視察2026×白黒つけない会議×デジタル民主主義の川の流れを見る×サステナブル・ブランド国際会議_2026×飛行機でxreal_one×衆院選2026×日テレNEWS×2024衆院選×ブロードリスニング×2024都知事選でのマイナ投票×ブロードリスニング:みんなが聖徳太子になる技術×tokyoai×激動の2024年5月下旬×シビックテックによる、社会と民主主義のアップデート×ブロードリスニングが1年で標準戦略に×チームみらいの社会実験「しゃべれるマニフェスト」から得られた知見×polis:_scaling_deliberation_by_mapping_high_dimensional_opinion_spaces×code_for_japan_summit_2025×cartographerによる章立て変更×主観か客観かではなく、一人の主観から大勢の主観へ×デジタル民主主義をスケールさせるには?×アテンションリソースとレポーティングの分離→

- →安野_貴博×鈴木_健×東_浩紀×プルラリティ×ゲンロン250626×ised×デジタル民主主義2030×アメリカ大統領選2024ロードトリップ×ハンナ・アーレント×革命について×革命×自由の創設×タウン・ミーティング×評議会×natality×政府効率化省×doge×なめらかな社会とその敵×21世紀のイデオロギー×差異があるという意味において平等×協力の深さと広さのトレードオフ×pluralityとハイプカーブ×ハイプカーブ×community_notes×pol.is×pol.isでのuberの議論×quadratic_voting×quadratic_funding×Talk to the City×ブロードリスニングが国会で野党が総理大臣に質問するために使われた事例×ハーバーガー税×joi_ito×創発民主制×weblog×草の根の民主主義×emergent_democracy×伊藤穣一×ブログ×rss×双方向メディア×下からの自己組織化×歴史は循環する、しかし内容はより高次のものとなる×似た物が昔にもあった型思考×テクノ封建制×civilization×東京大学pluralityセミナー2025-05-12×統合テクノクラシー×企業リバタリアニズム×デジタル民主主義×ブロードリスニングが1年で標準戦略に×ひまわり学生運動×radicalxchange×why_i_am_not_a_market_radical×plurality(2022)×pluralityは無色の新語として作られた×tokyo_plurality_week_2025×d/acc×マルクス主義×加速主義×柄谷行人×世界史の構造×マルクスその可能性の中心×探究_ⅰ×誤配×ルクレティウス×ずれ×すべてのものには裂け目がある。そこから光が差し込む×違いを越えて協働するための技術×一般意志×全体主義×単一性×エロイーズ×訂正可能性×垂直的×単一的×カール・シュミット×カール・シュミットの「議会批判」と「独裁」論×コネクテッド・ソサイエティ×ダニエル・アレン×規範的plurality×アジェンダ設定の権限を人々に開放する×請願権×オンライン請願×james_s._fishkin×詐欺犯罪危害防制條例×mini-public×いどばた政策×stanford_online_deliberation_platform×forkability×正統性×自己主権型アイデンティティ×伊藤_孝行×安野チーム台湾報告会×audrey+glen+colin+pmt研究会×【オードリータン✖️小川淳也】未来を共創するデジタル民主主義×玉木雄一郎+Plurality×愚行権×audrey+tbs_cross_dig×裏ハイデガーとしてのアーレント×今北勢問題×訂正可能性の哲学×家族性×家族×動的な認知的膜×ホロン×クリプキのクワス算×truth_social×政治家は猫になる×社会資本が王である世界×アテンションエコノミー×贈与経済×台湾の同性婚は親族にならない×2ステップの熟議×アーレントのwork×ファンダム→

- →選挙は4年に一度5bit送信する遅い通信だ×デジタルネイティブは4年に1度のアップロード帯域で十分とは思わない×if文から機械学習への道×どんどん複雑な条件分岐になっていく×cultural_preferences_for_formal_versus_intuitive_reasoning×教師あり学習×ロジスティック回帰×決定木×家族的類似性×東洋人はロジスティック回帰で西洋人は決定木×ルールベースパラダイムが重み付き和パラダイムに負けたエポック×vibe_coding×一部が消えて一部残り新しく生まれる×captcha×人間でないユーザ×認知戦×輿論戦×法は社会のos×九電玄海原発、ドローン侵入か×ウクライナ向け「ストライクキット」3.3万台供給×共有地の悲劇×ossで共有地の悲劇が起こることにどう対処するか×大きな政府と小さな政府×「大きな政府/小さな政府」は誤った二項対立×オストロム×公共財×共有資源×cpr×common-pool_resource×connections_between_indivisuals_as_first-class_objects×intersecting_group×新しいものは登場前にその価値を見積もることができない×ブロードリスニング×ai_objectives_institute×Talk to the City×デジタル民主主義2030×広聴AI×ブロードリスニングが国会で野党が総理大臣に質問するために使われた事例×日本維新の会のブロードリスニング事例×polis×既存のsnsは個人に注目させるが、polisは個人ではなく集団に注目させる×citizens_foundation×your_priorities×リプライさせない仕組み×別席調停×左派がよい主張をしているなら、右派がやるべきことは同じくらいよい主張であり、戦うことではありません×いどばたシステム×bitcoinはお金、ethereumはコンピュータ×中央集権の3つの軸×polymarket×1人1票×quadratic_voting×quadratic_funding×vitalik_buterin×gitcoin_grants×retroactive_public_goods_funding×futarchy×an_introduction_to_futarchy×幅がある→

- →いどばたシステム×blu3mo×自動生成される投票×cartographer初見の感想×自由記述と投票は誤った二者択一×幅のあるものに対して点推定してしまう×目的指向組織×ダンバー数×いどばたビジョン×単一の目的に邁進する×チームのメンバーのビジョンをアライン×aはbよりも優先すべきか?は良くない質問×cartography×crowdsourced_adaptive_surveys→

- →audrey_tangのright_livelihood受賞×デジタル民主主義2030×Cartographer×いどばたシステムv2×いどばたビジョン×いどばた政策×いどばたシステムv1×aiが仲介するコミュニケーション×discourse×blu3mo→

- →11/18(火)×2024年振り返り×世論地図2024振り返り×世論地図×Talk to the City×ブロードリスニング×しゃべれるマニフェスト×チームみらい2025参院選「しゃべれるマニフェスト」オープンデータ×チームみらいの社会実験「しゃべれるマニフェスト」から得られた知見×devinを見る会×scott_wu来日×devin使ってみてどうだった?_~活用事例と導入時のポイント~×llmを使いこなすエンジニアの知的生産術(講演資料)×未踏ジュニア×一般社団法人未踏の理事を退任しました×広聴AI×jigsaw_sensemaker×tttc勉強会×advanced_voice×aipm2025-03-11×日記2025-04-05→

- →Talk to the City試す×polis×意見のクラスタリング×Talk to the City×トピックのクラスタリング×Talk to the Cityのクラスタリング×bertopic×countvectorizer×著作権法30条の4×著作物に表現された思想又は感情の享受を目的としない利用×センチメント→

- →主観か客観かではなく、一人の主観から大勢の主観へ×ブロードリスニング×情報の複製により情報発信は効率化されたが、受信は改善しない、情報を減らす技術が必要×要約技術×関_治之×シビックテックによる、社会と民主主義のアップデート×polis×Talk to the City×andrew_trask×一人の人間が何百万人と対話することが可能になる×広範囲の傾聴×広聴×多聞×広範な傾聴×デジタル広聴×安野たかひろ氏が東京都知事選に出馬へ×glen_weyl×知的生産性×生身の人間×人間増強×plurality×broad_listening×deliberation×熟議×polisをもっとやりたい×多重視点×生煮えのトピック×切り口→

- →polis型×投票行列×vote_matrix×ボーリンググリーン×インタビュー型×デジタル民主主義2030×いどばたシステム×しゃべれるマニフェスト×チームみらいの社会実験「しゃべれるマニフェスト」から得られた知見×多数決×多数決を疑う×量的研究×質的研究×単語頻度分析×トピック抽出×Talk to the City×polis型データ×2022年参院選のpolis的可視化×オープンクエスチョンは答えにくい×一つのテキスト欄に過不足なく意見を整理して書くことが難しい×いどばたビジョン×みらいaiインタビュー×文法的クローズドクエスチョンを概念的に開く→

- →Cartographer×tokoroten×点推定×大きさがあるのでは?×幅がある×blu3mo×優先順位をつけることが政治の本質×優先順位×政治×目的指向組織×トレードオフの関係にあるものに優先順位をつける×トレードオフスライダー×分布を点だと思う間違い×点だと思い込む×単一の目的に邁進する×人生に影響を与えたゲームは何か→

- →サイボウズラボ勉強会×世論地図勉強会×2024衆院選×世論地図×世論地図のumap×濃い塊の抽出×カール・ピアソン×karl_pearson×多次元尺度構成法×主座標分析×自己組織化マップ×som×self-organizing_maps×カーネル法×再生核ヒルベルト空間×サポートベクターマシン×isomap×isometric_mapping×lle×locally_linear_embedding×対立次元×pca×UMAP×2022年参院選のumap可視化×polisクラスタ2つになる問題×東京大学谷口研究室・朝日新聞社共同調査×2022年参院選のpolis的可視化×convex_hull×code_for_japan_summit_2024×世論地図3970人umap×dbscan×高次元泥団子×集団極性化×匿名の市民の意見ベクトルはそんなに明瞭に別れてない×umapの結果をクラスタリングするべきか×tsneの結果のクラスタリングは慎重に×賛成反対データのumap×シン東京2050ブロードリスニング×テキスト埋め込みベクトルの分布×text-embedding-3-large×小さな粒のある一つの塊×クラスタリングとパーティショニング×k平均法×クラスタリング×spectralclusteringとhdbscanの違い×日テレNEWS×2024衆院選×ブロードリスニング×aiによるクラスタ解説×濃いクラスタ抽出×pTTTC2024-11-12×外れ値×まずは大雑把に×全体像を把握したい×talk_to_the_city_turbo×TTTC: AIと著作権に関するパブリックコメント×Talk to the City勉強会×kj法×発想法×川喜田二郎×凝集型階層的クラスタリング×離れザル×側面×word2vecによる自然言語処理×概念の類似度は距離ではない×50枚のkj法は10時間の想定×5年間で129枚しかkj法をしていない→

- →サイボウズラボ勉強会×ブロードリスニングの「あの図」勉強会×ブロードリスニング×都知事選2024×Talk to the City×日テレNEWS×2024衆院選×ブロードリスニング×世論地図×plurality和訳×japan_choice×議員pedia×投票ナビ×政治参加×社会参加×じぶんごと×可視化×11万人の意見クラスター分析×polis×aiによるクラスタ解説×mielka×結城_東輝×台湾デジタル発展省×mashbean×funding_the_commons_tokyo_2024×glen_weyl×glen+japanchoice×plurality×大きな物語×polis体験レポート:同性婚を合法化すべきか×polis勉強会×polis:_scaling_deliberation_by_mapping_high_dimensional_opinion_spaces×主成分分析×シルエット係数×fisherの正確確率検定×convex_hull×d3.js×モバイルファースト×majority_judgement×多数決×polis_2.0×AIクラスタ解説×会社さんはいない×2022年参院選のpolis的可視化×東京大学谷口研究室・朝日新聞社共同調査×公明正大→

- →funding_the_commons_tokyo_2024×plurality_in_japan×ftctokyo!×ftctokyo×Talk to the City×audrey_tang×glen_weyl×plurality:_technology_for_collaborative_diversity_and_democracy×チームワークあふれる社会を創る×理想への共感×100人100通りの働き方×100人100通りの人事制度×デジタルツール×多様性×funding_the_commons×柄谷行人×交換様式論×デジタル民主主義×交換様式a×colors.js事件×beyond_public_and_private×安宅_和人×intersecting_group×21世紀のイデオロギー×統合テクノクラシー×企業リバタリアニズム×ブロードリスニング×主観か客観かではなく、一人の主観から大勢の主観へ×vtaiwan×polis×メディアとしてのグループウェア×生産性向上ソフトウェア×ソーシャルメディア×一丸となって共通の目標を達成×変化に適応×プロソーシャルメディア×グループウェア×副業×複業×パラレルワーク×理解され、実行されるまでの時間を短縮する×アジェンダ設定の権限×参加型政策立案×参加型予算編成×majority_judgement×quadratic_voting×kj法の累積的効果×vtaiwanでuberに関する議論がどう進展したか×Meetup with Audrey & Glen×audrey+glen+halsk@cybozu×未来はすでにまだらに存在している×組織の境界×なめらか化×開門造車、你行你来×思惟経済説×plurality質疑@ftctokyo→

- →plurality_tokyo_namerakaigi×サイボウズラボ勉強会×pol.is×community_notes×メカニズムデザイン勉強会×majority_judgement勉強会×pluralityとpolis勉強会×polis勉強会×quadratic_votingとplural_management勉強会×Talk to the City勉強会×世論地図勉強会×高次元データ分析勉強会×デジタル民主主義研究ユニット×ピボット×古典期アテネの民主主義のスケール×国民こそが唯一の正統な権威である×フランス革命×フランスでの女性参政権×一人一票×未成年者には投票権がない×成年被後見人の選挙権×ドメイン投票方式×デメニー投票×デーメニ投票×quadratic_voting×glen_weyl×qv×radical_markets×audrey_tang×vitalik_buterin×quadratic_funding×audrey_tangのqv×glen_weylのqv×quadratic_votingがシナジーの発見に有用×台湾総統杯ハッカソン×qvは投票しないことに意味のあるメカニズム×「投票しないことは良くないことだ」は根拠のない思い込み×vitalik_buterinらのquadratic_funding×a_flexible_design_for_funding_public_goods×akb48総選挙×gitcoin×gitcoin_grants×公共財×リソースの再分配×社会的意思決定×メカニズムデザイン×多数決×くじ引き×抽選制×抽籤制×プラトン×アリストテレス×ジェームズ・マディソン×ジョン・スチュアート・ミル×アレクシ・ド・トクヴィル×選挙は4年に一度5bit送信する遅い通信だ×ブロードリスニング×polis×pol.isでのuberの議論×metaがファクトチェックを廃止×community_notesにおける行列分解を用いた信頼度スコアリング×多様な主体から支持されることを評価する仕組み×Talk to the City×日テレNEWS×2024衆院選×ブロードリスニング×シン東京2050ブロードリスニング×UMAP×世論地図×mielka×2024衆院選×japan_choice×meta-polisの構想×mashbean×協力の深さと広さのトレードオフ×plurality本×aiあんの×タウンミーティング×非同期化×空間と時間の制限から解き放つ×chatgptとaiあんののコミュニケーションの形の違い×ai政治家の3つのレベル×aiが間に入って非同期化×open_space_technology×アジェンダ設定の権限を人々に開放する×vitalik×主観主義×3つのイデオロギーの間に2つの対立軸がある×aiが仲介するコミュニケーション×bluemo×intersubjective_model_of_ai-mediated_communication:_augmenting_human-human_text_chat_through_llm-based_adaptive_agent_pair×時間の制約×心理的安全性×緩やかに繋ぐ×デジタル民主主義2030×同じ時間と場所を共有できない人に機会を用意×metapolis×スケーラビリティ×デジタル民主主義×コミュニティ×大規模コラボレーション×xy問題×熟議のための4つのステップ×リプライはスケールしない×リプライさせない×your_priorities×コトノハ→

- →pluralityとサイボウズ(2023)×ブロードリスニング×都知事選2024×日テレNEWS×2024衆院選×ブロードリスニング×シン東京2050ブロードリスニング×デジタル民主主義2030×広聴AI×いどばたシステム×aiの進歩とplurality×plurality本発売×tokyo_plurality_week_2025×チームみらい×デジタル民主主義2030、新ボード体制のお知らせ×チームみらいのソフトウェア開発の4割はai×pluralityとは×singularityでいいのか?×効率と包摂のトレードオフ×100人100通りの働き方×サイボウズの自由すぎる働き方はこんなやり方で管理されていた×メディアとしてのグループウェア×anti-social_media×pro-social_media×政治的対立×polis×polis体験レポート:テロの原因究明をするか×kintone×みらいいどばた会議×デジタル民主主義×代表制民主主義×ヒエラルキー×ティール組織×組織統治メカニズム×ブロードリスニングが1年で標準戦略に×日記2025-07-16→

- →未踏ジュニア×plurality_tokyo_2023×ブロードリスニング×主観か客観かではなく、一人の主観から大勢の主観へ×激動の2024年5月下旬×TTTC: AIと著作権に関するパブリックコメント×funding_the_commons_tokyo_2024×ftc2024安野+audrey×plurality_in_japan×日テレNEWS×2024衆院選×ブロードリスニング×シン東京2050ブロードリスニング×デジタル民主主義2030×広聴AI×Talk to the City と広聴AIの歴史×ブロードリスニングが国会で野党が総理大臣に質問するために使われた事例×りっけんai井戸端会議×再生の道ブロードリスニング×ブロードリスニングが1年で標準戦略に×plurality本×協力の深さと広さのトレードオフ×偽情報×audreyとd/accとdifferential×民主主義は社会的技術×qarasu-14bに質問をする×reasoningモデル×無意識データ民主主義×未成年者には投票権がない×台湾のjoinで高校生の提案が制度改善につながった×親ソーシャルメディア×橋渡しする意見×ブリッジングボーナス×灘校土曜講座→

- →Talk to the City勉強会×ブロードリスニング×Talk to the City×TTTC: AIと著作権に関するパブリックコメント×Talk to the CityでPlurality本の内容を可視化×デジタル民主主義×デジタル投票×民主主義×投票×政治家×公職選挙法×参加型予算編成×参加型予算編成:東京の事例×plurality×audrey_tang×funding_the_commons_tokyo_2024×good_enough_ancestor→

- →安野チームに参加したきっかけ×未踏ジュニア×plurality_tokyo_2023×rickshinmi×安野_貴博×plurality本×関_治之×思考の結節点2024-05-23×都知事選xデジタル民主主義×Talk to the City×gisele_chou×tkgshn×talk_to_the_city_turbo×11万人の意見クラスター分析×japan_choice×talk_to_the_city_scatter×aiパブコメ×TTTC: AIと著作権に関するパブリックコメント×シビックテックによる、社会と民主主義のアップデート×ブロードリスニング×broad_listening_in_practice×ブロードリスニングの「あの図」×2024→

- →直線的な時間軸×主観的な時間×行為と行為者の不可分性×主体客体交換×ジェンドリン哲学入門の時間の概念×blu3mo×ユージン・ジェンドリン×弁証法×似ているものの違いに注目×経験の側面×埋められる穴×正孔×電子と正孔×過去と現在の交差点×過去の自分×共同注意→

- →サイボウズラボ勉強会×デジタル民主主義2030×join×市民参加型の政策形成プロセス×Talk to the City×東京都ai戦略いどばた会議×azure_blob_storage×azure_container_app×oss_weekly_reporter×o1_pro×gpt-4.5→

- →aiと著作権に関するパブリックコメント×Talk to the City×ブロードリスニング×全体感を抽出×パブコメの可視化×シビックテックによる、社会と民主主義のアップデート×クラスタを掘り下げる×aipubcom→

- →dena_techcon_2025×なぜそれが成り立つのか×コーディングを支える技術×プログラミング言語の背後にある設計思想×単なるスキル習得を超えた知的好奇心×エンジニアの知的生産術×自己改善へのこだわり×devin×技術の最前線に触れようとする姿勢×デジタル民主主義×ブロードリスニング×東京都知事選×安野たかひろ×Talk to the City×技術を社会に還元したい×plurality×社会的インパクト×デジタル公共資産基金×オープンソースの哲学×技術が公共財として機能する×サイボウズ・ラボ×一般社団法人未踏×報酬がゼロでも複業をやる×新しい学びや挑戦を優先するマインド×チームワーク×生産性向上×組織文化への貢献×外部脳×2日連続の登山×身体的な挑戦×知識共有に積極的×透明性×コミュニティへの貢献×よい方向性×民主主義のスケーラビリティ×mitou2024_demo_day×次世代のクリエイター支援→

- →サイボウズラボ勉強会×plurality_in_japan(サイボウズラボ)×funding_the_commons_tokyo_2024×Talk to the City勉強会×TTTC: AIと著作権に関するパブリックコメント×サイボウズと語ろうPlurality 多元性の実践と期待×2024-09-08-民主主義を支える技術×ブロードリスニング×meetup_with_thomas_hardjono×ソーシャル物理学×テクノロジーとわたしたちの「距離感」が変われば、誰も取り残されない社会がつくれるかもしれない×デジタル民主主義×ブロードリスニングの「あの図」×階層組織×ティール組織×個人情報とマネタイズ×成蹊大学×2019年度武蔵野市寄付講座「itとルールの今・未来」×計画経済×llmがもたらす組織構造の変化×ブラウン組織×plurality_tokyo×pluralityとpolis勉強会×主観か客観かではなく、一人の主観から大勢の主観へ×情報の複製により情報発信は効率化されたが、受信は改善しない、情報を減らす技術が必要×関_治之×激動の2024年5月下旬×ミーム化×asia_blockchain_summit_2024×サイロ化×組織の境界×なめらか化×plurality_in_japan×良い議論ができる場を可視化の後につける×可視化×aiあんの×u理論×ソーシャルフィールドを耕す×mashbean×dx&ai_forum_2024×生成aiで作るデジタル民主主義の未来×「聴く」「磨く」「伝える」のサイクル×human_in_the_loop×people_in_the_loop×オモイカネ勉強会×chatgptとaiあんののコミュニケーションの形の違い×社会的学習×アイデアの流れを混ぜてアイデアの多様性を増す×組織としての学習×集団的知性×複数組織とブロードリスニング×個人的文脈×当事者意識×ファウンダーマーケットフィット×熱意×proj-broadlistening×social_hack_day→

- →対立は恐れずに活用すべきエネルギー×airbox×相互運用性とスーパーモジュラリティ×quadratic_votingがシナジーの発見に有用×参加者が多いほど良いシグナルが得られる×地元発のプロジェクトを全国インフラ化する×多様な意見の橋渡しの価値が高い×joinでの賛成反対2カラム表示×署名した人にメールを送り、オンライン会合に来る人を募る×台湾の詐欺防止法におけるデジタル署名×help_the_helpers×10代の若者によるオンライン請願×trustlessではなくtrust-building×抗議とデモの違い×公共財×スーパーモジュラリティ×組み合わせによる相乗効果×vtaiwan×join.gov.tw×デモ×解決策の提示×二次投票×quadratic_voting×デジタル署名×did/vc×pol.is×Talk to the City×橋渡しボーナス×橋渡し×トラストレス×ブロードバンドは人権→

- →2022年参院選のumap可視化×pca×世論地図×東京大学谷口研究室・朝日新聞社共同調査×次元削減×Talk to the City×t-sne×bertopic:_neural_topic_modeling_with_a_class-based_tf-idf×bertopic→

- →望遠鏡×客観性×主観的解釈×取捨選択×要約×職人技×費用対効果×Talk to the City×要約職人×自動編み機×靴下職人×教会の権威失墜×科学の権威失墜×主観か客観かではなく、一人の主観から大勢の主観へ→

- →polis×pca×Talk to the City×UMAP×tttc的クラスタ説明生成×地図×データの多いpolisは半分こになりがち×イデオロギー・ベクトルの可視化×11万人の意見クラスター分析→

- →週記2024-09-07~2024-09-16×短距離走×気がついたら9月の半ばだった×2024-09-08-民主主義を支える技術×2024-09-10_polisの新ui×TTTCをAzure OpenAIで使う×p2024-09-12×ブロードリスニングの「あの図」勉強会×思考の結節点2024-09-14×ドラえもんのどら焼き屋さん物語×2024-09-08外部脳github作業×休むをする×さまざまな抽象度で問いを抽出→

- →open_science_framework×再現性の危機×arnold_ventures×メタサイエンス×center_for_open_science×特許権×期限付き独占権×enforcement×デファクトスタンダード×pocとpmfは違う×データ共有基盤×公共的情報インフラ×インフラ×インフラの予算でやる×予備自衛官×コスモローカル×funding_the_commons×earth_commons×pagoda_thailand_builder_residency×パゴダ×co-creative×コロプラ×御代田×開発合宿×データ活用基盤×federated_learning×秘密計算×protocol_labs×ニューロテック×gitcoin×quadratic_funding×optimism×token_house×dao_treasury×インパクト評価×ebpm×トニー・ブレア×intervention×介入×評価システムも評価される×ビジョナリーにcooが必要×AOIのTTTCページにAudrey Tangのコメントがある×ワイガヤ×出しつくした感×焼きなまし法×認知的体力が無限大×熱意のある人はリソース×pagoda×4seas×フォーシーズ×コミュニティマネージャ×信頼の醸成×democratic_inputs_to_ai×プロセス評価×sib×事業仕分け×競争性×ウェルビーイングインデックス×ウェルビーイング×well-being×歯ブラシ問題×相互運用性×interoperability×幸福の定義×人々の幸福の定義は人間が行う必要性がある×サイボウズと語ろうPlurality 多元性の実践と期待×aiによる統治×人間の意思決定×地域幸福度指標×デジタル庁×デジタル田園都市国家構想×移動式投票×曲線下面積×集団的意思決定×マッチング×レコメンド×複雑なものを複雑なまま理解する×2022年参院選のpolis的可視化×blu3mo×news_from_all_sides×つながり×昭和的価値観ai×polymarket×アイデアクラウド×hft→

- →人生の選択肢をどうやって知ったか?×aiにkj法を教える×Talk to the Cityを試したい×Talk to the City×kj法×kozaneba×Talk to the City勉強会→

- →樋口_恭介×bertopic×Talk to the City×安野たかひろ×polisからのエクスポート×日記2024-06-22×日記2024-06-24×日記2024-03-15×日記2023-06-23→

- →scrapbox×西尾泰和のscrapbox×scrapbox→cosense名称変更×西尾泰和のcosense×ポインター×ハンドル×誤った二者択一×第三の選択肢×西尾泰和の外部脳×外部脳×クローズドソース×プロプライエタリ×私の著作物をすべてcc-0にしたい×mem.nhiro.org×Talk to the City×フラクタル要約×西尾泰和の落書き×非言語的シンボル×落書き×scrapbox期×外部脳期×これは何?(~2024-09-08)×これは何?×2024-09-08外部脳github作業→

- →サイボウズラボユース夏合宿2024×open_space_technology×エストニア×台湾×チベット×山古志村×21世紀のイデオロギー×自由×効率×アルゴリズムによる最適化×aiによる統治×自由→力と格差×ossと小さな政府×熟議×polis×Talk to the City×ai_objectives_institute×stanford_online_deliberation_platform×ブロードリスニングとAIあんの×デジタル公共資本基金→

- →サイボウズ×plurality×funding_the_commons_tokyo×公共財としてのサイエンス×デジタル公共財×デジタル民主主義×オードリー・タン×グレン・ワイル×ブロードリスニング×多様な個性を重視する×異なる視点を持つ人々の協力×対話と議論×協力のための技術×シビックテック×code_for_japan×知的生産性×安野たかひろ×aiと人間の協調×統治形態×Talk to the City×aiによる統治×人間の意思決定×政治家は猫になる×22世紀の民主主義×21世紀のイデオロギー×broad_listening_in_practice×dig_dao×デジタル庁×web3.0×digdaoマッチングドネーション×quadratic_funding×代表制民主主義×市民参加×意思決定プロセス×納得感×社会的合意形成メカニズム×激動の2024年5月下旬×audrey+glen+halsk@cybozu×x_spaceの音声をダウンロードする→

- →polis2024年夏×デジタル民主主義×アジェンダ設定の権限を人々に開放する×Talk to the City×オープンデータ×polis準備:選挙ポスター×polis準備:_新しい民主主義×2024年夏polis祭り:インスタンスの準備×polis準備:自治体dxの情報システム共通化×polis準備:0歳投票権×polis準備:神宮外苑再開発→

- →aiと著作権に関するパブリックコメント×Talk to the City×Talk to the Cityのクラスタリング×都知事選xデジタル民主主義×talk_to_the_city_turbo×talk_to_the_city_reports×東京大学谷口研究室・朝日新聞社共同調査×ppolis2024-05-27×スモールスタート×Polisは意見のクラスタリング、TTTCはトピックのクラスタリング×Talk to the CityでPlurality本の内容を可視化→

- →tokyoai×高橋_直大×Talk to the City×安野たかひろ×東_浩紀×馬田_隆明×関_喜史×選挙活動dx×歴史の転換点×ひまわり学生運動×アラブの春×audrey_tang×大前提として劣化する×テクノロジーと民主主義の対立×良質な情報を持っていると予言の成功率が高まる×他人が価値を見出す前にポジションを取れ×デジタル民主主義×オモイカネ勉強会×日記2024-06-23×日記2024-06-25×日記2024-03-16×日記2023-06-24→

- →サイボウズラボ勉強会×plurality_tokyo×plurality×ブロードリスニング×polis×pluralityとpolis勉強会×polis勉強会×plurality_seoul×audrey_tang×gisele_chou×Talk to the City×ai_objectives_institute×deger_turan×aiと著作権に関するパブリックコメント×安野たかひろ氏が東京都知事選に出馬へ×マイナンバーカード×直接投票×オープンソース×デジタル公共財×人間増強×知的生産性の向上×都知事選でTalk to the Cityをする×tokyoai×主観か客観かではなく、一人の主観から大勢の主観へ×シビックテックによる、社会と民主主義のアップデート×手書きの図×polis:_scaling_deliberation_by_mapping_high_dimensional_opinion_spaces×polis体験レポート:同性婚を合法化すべきか×台湾の同性婚は親族にならない×vtaiwan×オープンガバメント×デジタル民主主義×透明性×参加型民主主義×アジェンダ設定の権限を人々に開放する×モデレーション×polisのモデレーション×AOIのTTTCページにAudrey Tangのコメントがある×集団的議論×集団的意思決定×peter_eckersley×electronic_frontier_foundation×let's_encrypt×certbot×privacy_badger×brittney_gallagher×Talk to the CityでPlurality本の内容を可視化×bertopic×bertopic:_neural_topic_modeling_with_a_class-based_tf-idf×UMAP×hdbscan×mashbean×初探_polis_2.0:邁向關鍵評論網絡×熟議×レジリエンス×双方向的マスコミュニケーション×国民ラジオ×一方向的マスコミュニケーション×聞く姿勢×デジタルネイティブは4年に1度のアップロード帯域で十分とは思わない×雪玉×polis_2.0×発想法×川喜田二郎×kj法×凝集型階層的クラスタリング×u理論→

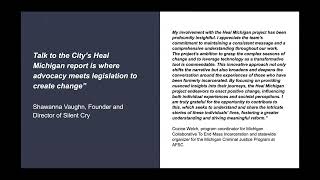

- →Talk to the City×brittney_gallagher×deger_turan×ai_objectives_institute×silent_cry×社会復帰の課題×技術へのギャップ×雇用障壁×メンタルヘルスサポート×whatsapp×mashbean×障がい者×社会的弱者→

- →Talk to the City×polis×mashbean×plurality×100分de名著_ローティ『偶然性・アイロニー・連帯』×日記2024-02-07×日記2024-02-09×日記2023-10-31×日記2023-02-08→

- →渾沌をして語らしめる×学びて時にこれを習う×學而時習之、不亦説乎×探検の五原則×問題提起ラウンド×状況把握ラウンド×本質追求ラウンド×語るkj法図解×クラスタとの会話×Talk to the City×植え替えノート×移植×時の試練×kozaneba読書→

- →precise_zero-shot_dense_retrieval_without_relevance_labels×仮説的文書埋め込み×Hypothetical Document Embeddings×hyde×instructgpt×contriever×埋め込みベクトル×blu3mo→

- →scrapbox自動翻訳×blu3mo×翻訳ではなくブログ文章生成×gptにブログ記事を作らせる実験×アイデアの価値の過大評価×内側の視点、外側の視点×投票は貢献であり信頼醸成×アクティブ読書×思考を深める×フォーマットを変えることによる知的生産×kj法×kozaneba読書×知識の「掘り下げ」と「積み上げ」の重要性→

- →チャットボット×リアクティブ×自発的×知的生産×機械がscrapboxを読む×機械がscrapboxに書く×puppeteer×blu3mo×pythonでscrapboxにimport×heroku×headless_chrome×自動生成ページを自動削除する×scrapboxはフローの場ではなくストックの場→

"Engineer's way of creating knowledge" the English version of my book is now available on [Engineer's way of creating knowledge]

(C)NISHIO Hirokazu / Converted from [Scrapbox] at [Edit]